引言

随着大数据时代的到来,数据分析成为了企业决策的重要依据。Hive作为Apache Hadoop生态系统中的一个重要组件,被广泛应用于大数据处理和分析。高效的Hive执行语句能够显著提升数据分析的效率,降低成本。本文将探讨如何编写高效的Hive执行语句,以提高数据处理的性能。

选择合适的文件格式

在Hive中,选择合适的文件格式对于提高执行效率至关重要。常见的文件格式包括TextFile、SequenceFile、ORCFile和Parquet等。以下是几种常见文件格式的特点及适用场景:

TextFile:最简单的文件格式,适合小规模数据,但存储效率低,不适合大数据量。

SequenceFile:支持压缩和分区,适合大规模数据,但序列化/反序列化开销较大。

ORCFile:提供了更好的压缩和查询性能,适合大规模数据仓库。

Parquet:支持列式存储,压缩和查询性能优异,适合大规模数据仓库和在线分析。

根据实际需求选择合适的文件格式,可以有效提升Hive查询的执行效率。

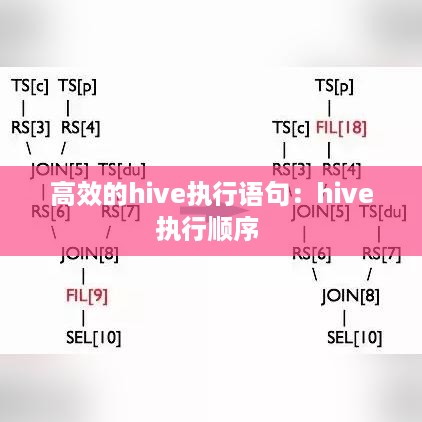

优化Hive查询语句

编写高效的Hive查询语句是提升执行效率的关键。以下是一些优化技巧:

以下是具体优化方法的详细说明:

避免全表扫描:通过添加WHERE子句过滤数据,减少需要扫描的数据量。

使用WHERE子句过滤数据:在WHERE子句中使用索引,可以提高查询效率。

使用JOIN优化:尽量使用内连接,避免使用外连接;在JOIN操作中使用索引,可以提高查询效率。

使用GROUP BY优化:在GROUP BY操作中使用索引,可以提高查询效率。

使用LIMIT限制结果集大小:在查询中使用LIMIT限制结果集大小,可以减少查询时间。

合理配置Hive参数

Hive提供了许多参数,用于调整查询性能。以下是一些重要的Hive参数及其作用:

hive.exec.parallel:开启并行执行,提高查询性能。

hive.exec.parallel.thread.number:设置并行执行线程数,根据实际情况调整。

hive.exec.dynamic.partition:开启动态分区,提高分区查询性能。

hive.exec.dynamic.partition.mode:设置动态分区模式,根据实际情况调整。

hive.exec.reducers.bytes.per.reducer:设置每个reducer处理的数据量,根据实际情况调整。

合理配置Hive参数,可以显著提升查询性能。

总结

编写高效的Hive执行语句对于大数据处理和分析至关重要。通过选择合适的文件格式、优化查询语句、合理配置Hive参数等措施,可以有效提升Hive查询的执行效率。在实际应用中,需要根据具体场景和数据特点,不断优化和调整,以达到最佳性能。

本文旨在为广大Hive用户提供一些优化技巧,希望能对您的数据分析工作有所帮助。

转载请注明来自无忧安证,本文标题:《高效的hive执行语句:hive执行顺序 》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...